迪士尼彩乐园3系统 阿里云通义开源首个长文本新模子, 百万Tokens管束性能超GPT-4o-mini

发布日期:2024-08-31 00:03 点击次数:140

当DeepSeek新模子DeepSeek-R1转机科技界的同期,1月27日凌晨,阿里云通义重磅开源救济100万Tokens高下文的Qwen2.5-1M模子,推出7B及14B两个尺寸,均在管束长文本任务中相识卓绝GPT-4o-mini;同期开源推理框架,在管束百万级别长文本输入时可完毕近7倍的提速。

百万Tokens长文本,可换算成10本长篇演义、150小时演讲稿或3万行代码。两个月前,Qwen2.5-Turbo升级了百万Tokens的高下文输入才气,广受开荒者和企业宽饶。如今,开源社区可基于全新的Qwen2.5-1M系列模子,进行长篇演义或多篇学术论文的瓦解,或是探索仓库级代码的分析和升级。

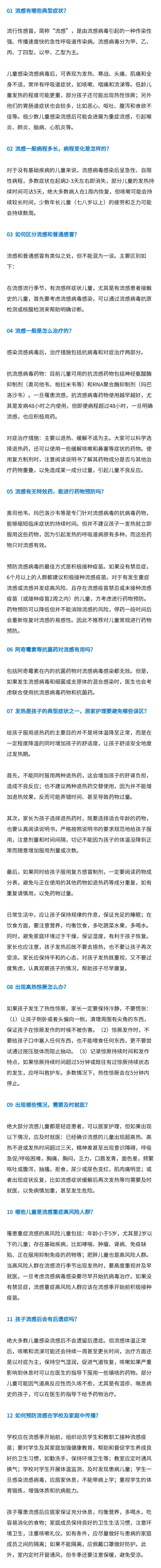

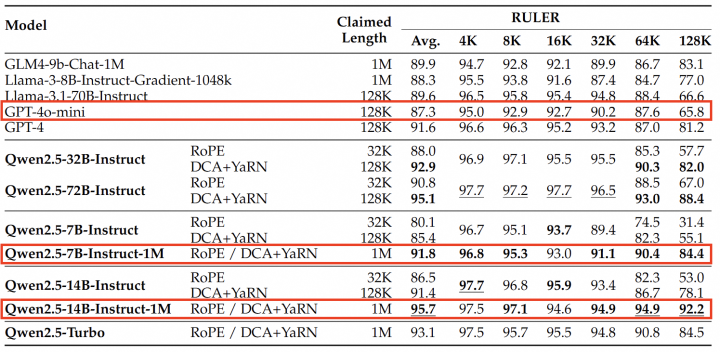

Qwen2.5-1M领有优异的长文本管束才气。在高下文长度为100万Tokens的大海捞针(PasskeyRetrieval)任务中,Qwen2.5-1M八成准确地从1M长度的文档中检索出躲闪信息,仅有7B模子出现了少许舛错。在RULER、LV-Eval等基准对复杂长高下文理撤职务测试中,Qwen2.5-14B-Instruct-1M模子不仅打败了自家闭源模子Qwen2.5-Turbo,还相识卓绝GPT-4o-mini,为开荒者提供了一个现存长高下文模子的优秀开源替代。

大模子的长文本测验需要耗损无数的测度打算资源,彩乐园官网通义团队通过迟缓延迟长度的设施,从预测验到监督微调再到强化学习等多个阶段,高效地将Qwen2.5-1M的高下文长度从4K延迟到256K;再通过长度外推的技巧,翻新引入DualChunkAttention机制,在无谓独特测验的情况下,将高下文长度高性能的相识延迟到1M,从而在较低本钱下罢明晰Qwen2.5-1M模子。

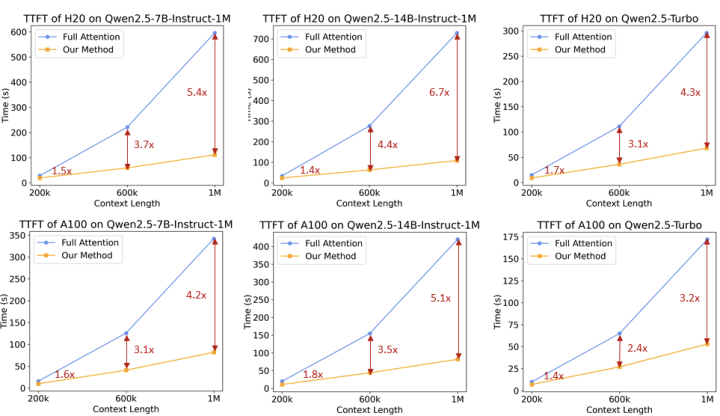

同期,为了加速推理速率,通义团队在vLLM推理引擎基础上,引入基于Minference的稀少谨防力机制,并在分块预填充、集成长度外推决策和稀少性优化等多设施翻新蜕变。基于这些蜕变的推理框架灵验地加速了模子推理速率,在不同模子大小和GPU拔擢上,管束1M长度输入序列的预填充速率提高了3.2倍到6.7倍。

据了解迪士尼彩乐园3系统,Qwen2.5-1M一经在魔搭社区ModelScope和HuggingFace等平台开源,开荒者可赶赴下载或径直体验模子;联系推理框架也已在GitHub上开源,匡助开荒者更高效地部署Qwen2.5-1M模子。开荒者和企业也可通过阿里云百真金不怕火平台调用Qwen2.5-Turbo模子API,或是通过全新的QwenChat平台体验模子性能及成果。

迪士尼彩乐园3系统 ♂CBA全明星妙技大赛名单: 徐杰&a

迪士尼彩乐园官网人类 火箭双杀骑士, 快船力克雄鹿, 湖东谈

迪士尼彩乐园3系统 雷军直播封禁一个小时, 举报者这样暗意,

迪士尼彩乐园3系统 英超积分榜, 利物浦阿森纳赓续领跑, 曼

彩乐园官网 奇瑞iCARV23认识: 复旧“方盒子”SUV,

迪士尼彩乐园官网人类 海外金价反弹 带动港股黄金板块上扬 中